Recientemente, varios expertos en ciberseguridad han alerta sobre un nuevo tipo de estafa. Se trata de los riesgos que puede tener la tecnología deepfake, cuyo uno de sus principales objetivos es el engaño mediante la difusión de información falsa, práctica que cada vez es más habitual entre la ciberdelincuencia, principalmente en periodos electorales.

Le puede interesar: Daviplata: Recomendaciones para evitar estafas de ciberdelincuentes

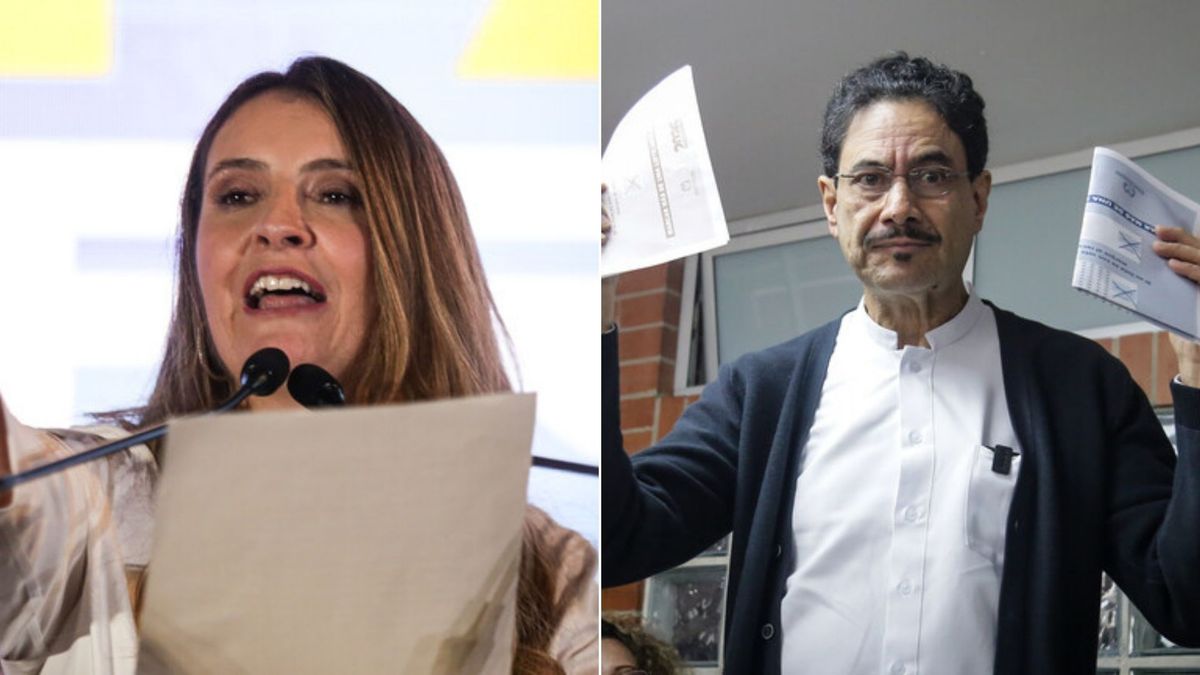

“El deepfake es fabricado a través de Inteligencia Artificial y crea imágenes, sonidos y vídeos engañosos convincentes, combinando el concepto de aprendizaje profundo con algo falso. Puede, digamos, mostrar a un personaje famoso diciendo algo que en realidad no ha dicho. Y esto es muy grave porque puede difundir noticias falsas que cambien la percepción de la opinión pública, lo que puede tener un impacto tremendo en unas elecciones, por ejemplo”, explica José Rosell, socio-director de S2 empresa especializada en ciberseguridad y gestión de sistemas críticos

Los tipos de deepfakes

Campañas de desinformación en las que se edita el contenido legítimo para cambiar el significado original de una noticia o vídeo. En esta modalidad se incluye el uso de imágenes de una persona que no se encontraba en el lugar como, por ejemplo, pornografía de venganza.

“Todo lo que se necesita para el uso de esta tecnología podemos encontrarlo en los mercados clandestinos, pero también en foros abiertos como GitHub. Cada vez resulta más sencillo conseguirlos y esto ha hecho que se haya incrementado el caso de ciberestafas de phishing. Normalmente haciéndose pasar por un político, un líder empresarial u otras personalidades famosas”, indica Enrique Fenollosa, LATAM General Manager de S2 Grupo.

Los peligros y objetivos de los ciberdelincuentes con el uso de los deepfakes son principalmente: la desestabilización de organizaciones a través de afirmaciones falsas y engaños; la pornografía de personajes famosos (se calcula que representa hasta el 96 % de los deepfakes que circulan por Internet); la manipulación electoral; la ingeniería social a través de audios haciendo creer que una persona de confianza ha dicho algo; ataques de desinformación automatizados como teorías de conspiración o robos de identidad de personas reales en los que se crean documentos falsos o se falsifica la voz de las víctimas.

Las principales estafas

De acuerdo con los especialistas de S2 Grupo, las ciberestafas más comunes relacionadas con los deepfakes son:

Estafas de mensajería. Business E-Mail Compromise (BEC). Aunque esta estafa ya es muy común sin la tecnología deepfake, los estafadores también pueden usar videollamadas para hacerse pasar por alguien de la empresa y pedir dinero.

Confección y secuestro de cuentas. Evadiendo la verificación de identidad, los delincuentes pueden crear cuentas en bancos con documentos de identidad robados y retirar o transferir dinero.

Chantaje. Los ciberdelincuentes pueden crear tecnologías deepfake para usarlos como método de extorsión.

Estafas de soporte técnico. Por ejemplo, pueden usar identidades falsas para crear ingeniería social con el fin de que los usuarios compartan credenciales de pago.

Secuestros de dispositivos IoT. Como los deepfakes pueden suplantar la voz o la apariencia física de una persona, pueden usarse para desbloquear dispositivos.

¿Cómo evitar ser estafado?

Aunque es difícil reconocer un deepfake, se pueden detectar al observar movimientos forzados o actividades inusuales como el movimiento ocular antinatural, la falta de parpadeo, las expresiones faciales, forma del cuerpo o cabello antinaturales. Además, los deepfakes no pueden replicar los colores de la piel.

La posición facial es otro posible indicativo de que lo que estamos viendo no corresponde con la realidad. Hay veces en las que a través de la iluminación es posible detectar sombras fuera de lugar. En otras ocasiones, es evidente la mala sincronización de las palabras y la gesticulación en la boca de la persona que está hablando.

Le puede interesar: ¿Quiere migrar a EE. UU.? Consejos para no caer en estafas

Desde S2 Grupo se hacen las siguientes recomendaciones para evitarlos:

- Activar el doble factor de autenticación. Se recomienda a las organizaciones autenticar a un usuario con tres factores básicos: algo que el usuario tiene, algo que el usuario sabe y algo que el usuario es.

- Minimizar la exposición de imágenes personales de alta calidad en redes sociales.

- Priorizar el uso de patrones biométricos (iris o las huellas dactilares) para verificar cuentas sensibles.